top of page

03

感知未见 - 大语言模型智能可穿戴

一种可穿戴设备,通过触觉反馈和自然语言为蒙眼者增强导航探索功能

将空间信息转化为直观的感官体验

项目简介

感知未见是一款实验性可穿戴设备,旨在探索通过替代感官输入进行导航的可能性。该设备结合触觉反馈与自然语言引导,帮助蒙眼个体间接理解空间信息。通过震动和语音提示,用户无需视觉输入即可在环境中导航,从而增强空间感知能力。本项目探讨了非视觉反馈如何改变感知方式,拓展了无障碍设计与大语言模型在导航与路径引导技术中的应用可能性。

梅洛-庞蒂(Merleau-Ponty)的“身体图式”(body schema)将我们的身体空间与外部世界联系起来,使意识植根于一个“意向弧”,这一弧整合了过去、未来、社会背景和物理经验(Merleau-Ponty, 1962)。这一框架将身体视为“活生生意义的纽带”,强调了身体与世界的不可分割性。在此基础上,具身认知(embodied cognition)对以大脑为中心的认知观提出批判,认为认知源于感觉—运动交互(sensorimotor interactions)。在《具身心智》(The Embodied Mind)一书中,瓦雷拉(Varela)、汤普森(Thompson)和罗施(Rosch)(1991)强调了身体与环境耦合在认知过程中的关键作用。

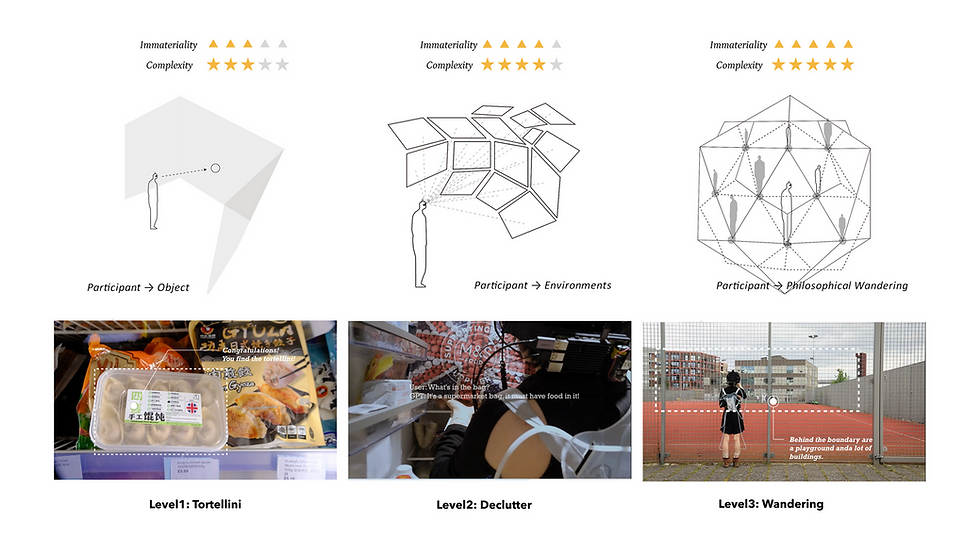

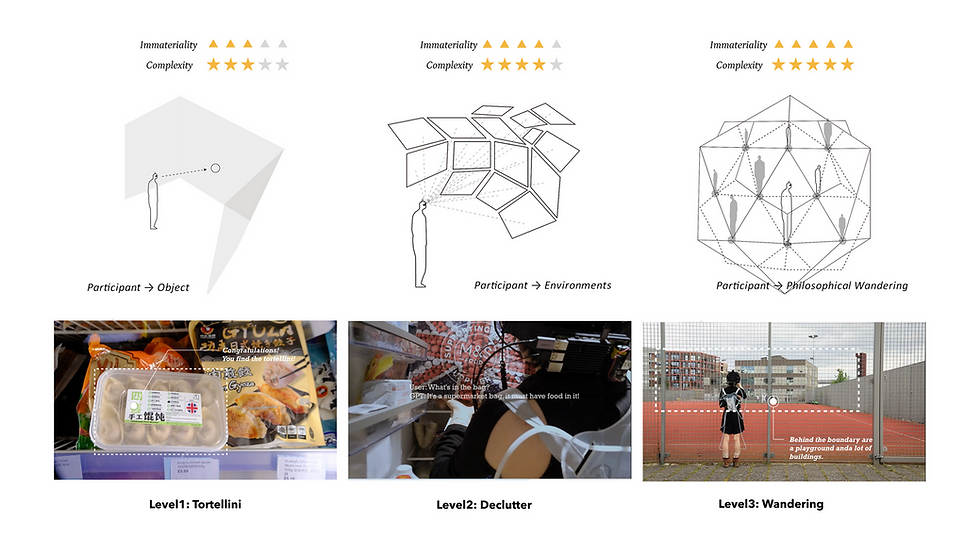

实验环节设计

前期实验主要任务是探索深度相机识别前方城市道路后,为蒙眼者设计制造电磁阀触摸识别界面。该界面可以为人们提供前方城市道路三维信息。该方向因成本以及技术原因并未实施。改为震动单元腰带负责基础避障。

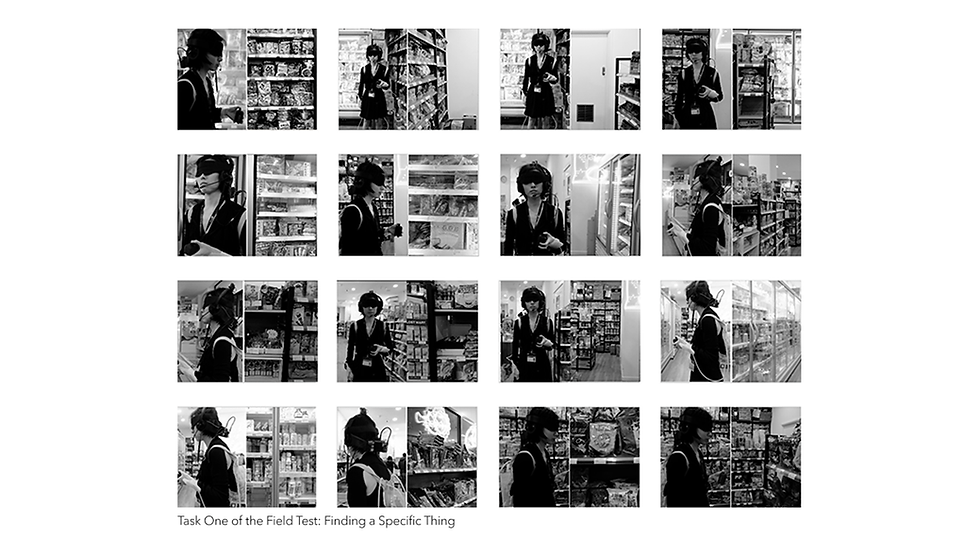

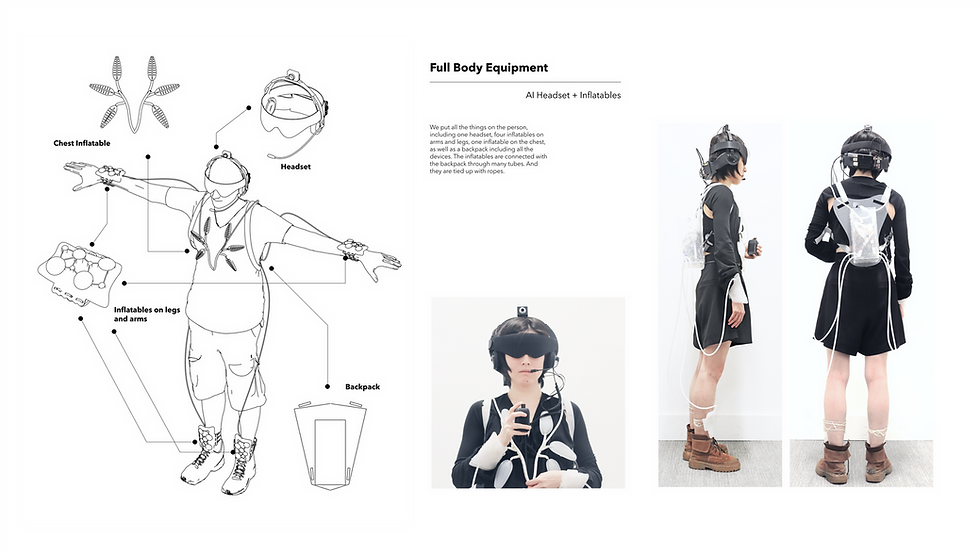

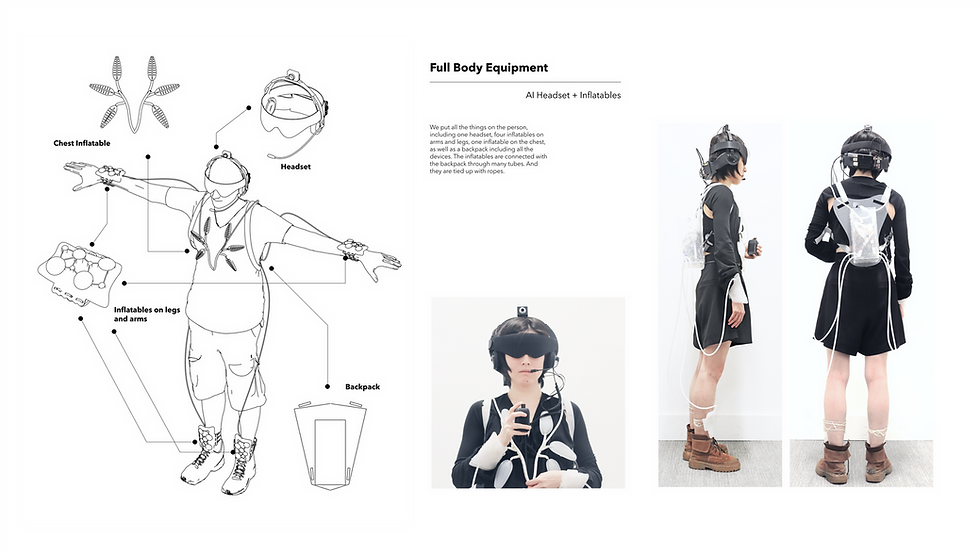

在这个项目中我们关注的是先进人工智能如何在不依赖视觉线索的情况下增强个体的导航能力。为此,我们开发了一款由人工智能驱动的可穿戴设备,该设备配备摄像头、触觉反馈系统,并使用 Raspberry Pi 处理输入信息,引导用户完成各种任务。

我们的实验性设计包含现场测试,参与者在蒙眼状态下由人工智能引导,在不同环境中完成任务。该实验为研究人工智能如何在动态的现实环境中超越视觉,重塑感官体验奠定了基础。

1/2

实体制造与测试

1/3

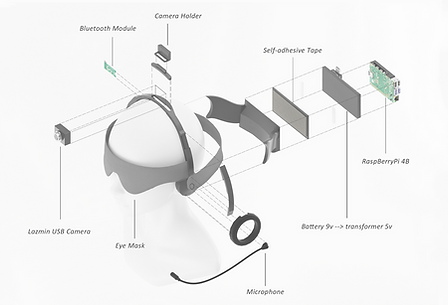

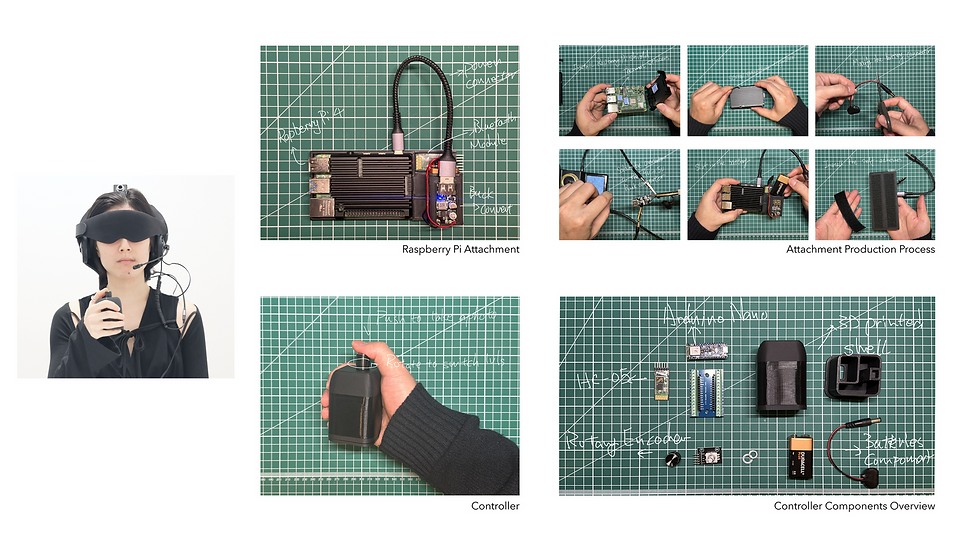

GPT驱动的AI头戴设备:我们设计的头戴设备是项目的关键组成部分,重点在于将各种现成组件进行符合人体工学的整合,以确保舒适性、功能性和安全性。头戴设备本身构成了基础结构,我们在此基础上安装了一个高质量的遮眼布,确保完全遮挡视觉,以准确模拟失明状态。一个摄像头组件用于捕捉实时视频流,这对于我们的AI处理视觉数据至关重要。

该设备功能的核心是一块Raspberry Pi(树莓派),它作为“大脑”,管理来自摄像头的数据并协调触觉反馈系统。在布置这些组件时,人体工学考虑至关重要,以确保设备在长时间佩戴时依然舒适。此外,我们还采用了可靠的电池解决方案,为Raspberry Pi提供稳定电力,保持设备稳定性并延长运行时间,无需频繁充电。这种精心组装的组件确保了我们的头戴设备既用户友好,又能有效实现其预期功能。

完整版项目作品预览

1/7

bottom of page